Вредоносное ПО (malware) - это назойливые или опасные программы,...

Тестирование «настоящих» аппаратных RAID-контроллеров является очень непростым занятием. Основных причин тому несколько. Первая – сложность сбора тестового стенда соответствующего уровня. Если делать все «правильно», то потребуется много жестких дисков, соответствующий корпус и достаточно мощная серверная платформа, в некоторых случаях – еще и быстрая сеть и клиенты. Вторая проблема заключается в том, что в большинстве случаев подбор конфигурации СХД – задача под конкретного заказчика и конкретные приложения. При этом вариантов существует слишком много, что бы можно было за разумное время охватить их все. Третий вопрос касается выбора тестовых приложений и сценариев. На практике потребителя интересуют именно его задачи с определенной нагрузкой, тогда как в лаборатории в данном случае обычно удобнее использовать синтетику.

Тем не менее, когда появилась возможность в некотором приближении разобраться с первой проблемой, захотелось вернуться к этому вопросу и попробовать провести для начала несколько тестов. Безусловно, выбранные конфигурации и бенчмарки, вызовут множество вопросов у читателей, особенно если они являются профессионалами в данной области. Но просьба отнестись к этому материалу как попытке возрождения обсуждения темы и в комментариях предложить идеи (желательно конструктивные), как, что и почему было бы интересно исследовать в рамках данного направления. Двигаться есть куда, но направлений слишком много и выбрать интересные можно только с вашей помощью.

Напомним, как и для чего используются RAID-массивы и контроллеры на традиционных винчестерах. Ключевых причин три. Первая – необходимость создания дисковых томов большого объема. Одиночные диски сейчас есть на 12 ТБ, так что если нужно больше – придется использовать несколько дисков. Вторая – требование высокой скорости чтения и записи. Один винчестер способен показать максимально около 200 МБ/с, так что если нужно больше – тоже требуется подключить несколько дисков и обеспечить возможность одновременной работы с ними. Третий момент, непосредственно связанный с первыми двумя, – реализация отказоустойчивого массива. Обратите внимание, что речь идет исключительно о сохранении данных при выходе из строя диска (или дисков), что конечно связано с общим понятием «надежность хранения», но не заменяет такой операции, как создание резервных копий. Именно последняя позволяет обеспечить восстановление в случае таких неприятностей, как удаление или изменение файлов.

Данное тестирование проводилось на сервере с платформой Supermicro X8SIL, процессором Intel Xeon X3430 и 8 ГБ оперативной памяти. Ему уже около десяти лет и конечно он как минимум морально устарел. Но, пожалуй, единственной серьезной претензией здесь может быть отсутствие поддержки PCIe 3.0. С другой стороны, 8 линий PCIe 2.0 – это тоже неплохо для массива из нескольких жестких дисков.

В тестировании принимали участие контроллеры Adaptec 6, 7 и 8-го поколений. К ним одним кабелем на четыре линии SAS подключался бекплейн поколения SAS1 с экспандером. Собственно за хранение данных отвечали восемь винчестеров Seagate Enterprise Capacity 3.5 HDD v4, модель ST6000NM0024 (6 ТБ, 7200 RPM, буфер 128 МБ, SATA, 512e).

Конфигурация массива – RAID6, размер блока 256 КБ. Все кэши для тома на контроллерах включены, остальные параметры по умолчанию, все контроллеры использовали батареи для резервного питания. Напомним, что для данных поколений адаптеров Adaptec можно переносить массивы без потери конфигурации и данных (причем не только «вверх», но и «вниз»), что, безусловно, очень удобно.

Для операционной системы в сервере был выбран Debian 9. Как обычно, со всеми обновлениями на момент проведения тестирования. Драйвера для контроллеров из состава дистрибутива, BIOS обновлены, для удобства управления установлен последний MaxView Storage Manager.

Тесты проводились на «сыром» томе, что еще больше уводит нас в сторону синтетики, однако позволяет более точно оценить возможности аппаратной конфигурации. В реальности же приложения и пользователи обычно работают с файлами, которые размещены на какой-то файловой системе, а доступ к ним может осуществляться не только локально, но и по сети с использованием определенных протоколов. И конечно все это заслуживает отдельного изучения.

В роли тестового пакета выступала утилита fio, в некоторой степени аналогичная известному пакету iometer. В отличие от него, она корректно работает в современных Linux и позволяет оценить сразу несколько параметров.

Файлы конфигурации утилиты имели следующий вид:

blocksize=256k | 4k

filename=/dev/sda

rw=read | write | randread | randwrite

direct=1

ioengine=libaio

iodepth=1 | 2 | 4 | 8 | 16 | 32 | 64

runtime=180

Где «|» подразумевает выбор одного из значений. Таким образом, исследовались операции последовательного чтения и записи с блоками размером 256 КБ и случайного чтения и записи с блоками по 4 КБ. Все тесты прогонялись с глубиной очереди от 1 до 64 и каждый занимал три минуты. По результатам смотрим на скорости в МБ/с, IOPS и задержки (clat avg в мс). При повторении обязательно перепроверьте имя устройства (filename=/dev/sda). Неверное указание этого параметра на тестах записи может привести к потере данных.

Как мы видим, опций у теста много. Кроме того, можно запустить и одновременно несколько операций. Так что все сочетания проверить просто невозможно и при выборе параметров стоит ориентироваться на характерные для требуемого варианта использования схемы. Ну и не будем забывать, что при особом старании (или везении) можно «положить» любую систему

Учитывая, что в массиве только восемь дисков, скорее всего, некоторые из характеристик будут ограничиваться именно возможностями диска, а не использованного контроллера. Последние, напомним, отличаются производительностью процессора, объемом памяти и некоторыми другими характеристиками.

Сначала стоит сделать замечание об использованном формате диаграмм. На каждом графике приводятся сразу два показателя – производительности и средней задержки в зависимости от параметра iodepth теста. При этом для последовательных операций мы выбрали более привычный показатель в мегабайтах в секунду, а для случайных – iops. В данном конкретном случае с фиксированным размером блока они прямо пропорциональны и равноценны с точки зрения оценки результата.

Начнем с наименее быстрого контроллера Adaptec ASR-6805, который появился на рынке более семи лет назад. Интересно, что, несмотря на его возраст, данная линейка все еще востребована потребителями, как бы странно это не звучало.

Кстати, заодно опишем схему именований – первая цифра показывает поколение, вторая (точнее одна или две – встречается и вариант 16) – число внутренних физических портов (объединенных по четыре в разъёмы SAS различных форматов), третья – число внешних портов, пятая указывает на тип шины (5 – это PCI Express). Дополнительно могут присутствовать суффиксы, указывающие на тип разъемов, сокращенный объем кэшпамяти, наличие дополнительных функций.

Итак, последовательные операции.

|

На чтении с нашего массива контроллер может обеспечить до 900 МБ/с. Судя по близости последней пары показателей и резкому росту задержек в последней точке, дальнейшего увеличения скорости можно не ждать. Очевидно, что при повышении глубины очереди будут только повышаться задержки, при этом общая скорость останется на указанном уровне.

На операциях записи картина немного иная – максимальное значение в 500 МБ/с достигается сразу на минимальной нагрузке. В дальнейшем мы видим только рост задержек при увеличении глубины очереди.

Таким образом, поставив целью допустимое время отклика массива, вы можете оценить возможную нагрузку по максимальному числу обращений.

Безусловно, если задача требует исключительно случайных операций доступа к данным, то сразу на ум приходит использование SSD, обеспечивающих просто совершенно другой уровень производительности. И проводимые на массиве тесты этого сценария являются в скорее иллюстрацией «самой плохой ситуации», чем отражением реального положения дел на практических задачах.

|  |

На чтении массив не вносит никаких «скрытых» расходов и мы видим рост IOPS при увеличении глубины очереди с одновременным ростом задержек. С этим контроллером я не проверял следующие значения iodepth, но как будет показано далее, IOPS имеют свой предел, после которого будет только расти время отклика с сохранением общей скорости. На график записи лучше не смотреть. Все очень и очень грустно. Накладные расходы RAID6 на операциях записи часто оцениваются как число дисков*IOPS одного диска/6. То есть на одну операцию записи контроллеру требуется по факту провести шесть операций (не считая математических расчетов) – чтение исходного блока, чтение двух блоков четности, пересчет, запись трех измененных блоков.

При случайной записи при любой глубине очереди производительность ограничена на уровне 300 IOPS (примерно 1 МБ/с) и сделать здесь почти ничего нельзя. К счастью, в реальной жизни ситуация необходимости 100% случайного доступа к десяткам терабайт данных случается редко, а кроме того, на помощь приходит кэш операционной системы.

Итак, для ASR-6805 на наших шаблонах мы получили – последовательное чтение и запись на уровне 900 и 500 МБ/с соответственно, случайное чтение и запись – примерно 1000 и 300 IOPS.

Переходим к следующему участнику. Модели ASR-7805 около четырех лет. Ключевые отличия этого поколения от прошлого – увеличение производительности процессора, в два раза больше объем кэшпамяти, шина PCIe 3.0, поддержка режима HBA, работа с ленточными библиотеками.

|  |

В целом, зависимость производительности от нагрузки сохраняется, но есть и некоторые отличия. На последовательном чтении можно получить более 900 МБ/с, но только при относительно небольшой глубине очереди, тогда как значения для последних строк существенно ниже. Аналогичная ситуация и с последовательной записью – если нагрузка невелика, то скорость близка к 700 МБ/с, но при росте глубины очереди она падает до 630 МБ/с.

|  |

На случайном чтении мы видим те же 1000 IOPS, а вот с записью данный контроллер справляется лучше – он способен обеспечить почти 400 IOPS.

Дополнительно с этим контроллером я протестировал случайное чтение с существенным увеличением глубины очереди.

Как и говорилось выше, на этом шаблоне можно получить и более высокие значения производительности, но цена (рост задержек) все-таки слишком высока. Итого для этой модели максимальные показатели составили – 960 и 680 МБ/с на последовательном чтении и записи, 1100 и 400 IOPS на случайном чтении и записи.

Последняя протестированная модель контроллера – ASR-81605ZQ. В данном материале ее дополнительные возможности (в частности, MaxCache) не использовались, так что результаты будут применимы и к «обычному» представителю серии. Эта линейка является последней актуальной из традиционных продуктов со стеком Adaptec. Более новые решения серии SmartRAID – это уже совершенно другая история. В восьмой серии появилась поддержка 12 Гбит/с SAS, накопителей с секторами 4kn, UEFI BIOS. Все это для данного теста не актуально.

На операциях случайного чтения все упирается в диски и мы снова видим те же 1100 IOPS в сочетании с 60 мс откликом. Да и запись тоже мало отличается от прошлой модели – около 400 IOPS.

По итогам тестирования можно сделать несколько выводов. Прежде всего, напомним, что касаются они исключительно протестированной конфигурации дискового массива. Во-первых, 6-я серия все еще может быть интересна для реальной работы. Во-вторых, более современные поколения хотя и показывают результаты выше, говорить о каком-то существенном их превосходстве пожалуй не стоит. Особенно это заметно на сравнении серий 7 и 8. Так что если в вашем сервере или СХД применяются массивы из относительно небольшого количества SATA винчестеров, можно обеспечить их эффективное (насколько это возможно) использование на любом из данных контроллеров. Но если встают вопросы производительности на случайных операциях в сочетании с томом большого объема, то к ним нужно подходить более внимательно. Привычный RAID6 на базе жестких дисков не способен здесь показать высокие результаты даже на современных аппаратных контроллерах. Да и случайное чтение тоже является непростой задачей для такой конфигурации.

Ранее публиковал первую часть, в которой описывались общие сведения о RAID контроллерах (), были вопросы и интерес, выкладываю уже «мясной» кусок. Здесь всё очень конкретно – подробная классификация контроллеров Adaptec, функции каждой серии контроллеров, таблицы, картинки и т.д.

Модельный ряд RAID контроллеров Adaptec.

Классификация контроллеров Adaptec.

Можно попробовать представить усиление функций стека относительно класса проектов в этой таблице графически, чтобы придать таблице наглядность.

Таблица применения моделей с точки зрения поддержки SSD дисков.

Еще более мощную поддержку использования большого количества SSD дисков на контроллере будут давать следующие поколения RAID контроллеров и HBA. Количество дисков, указанное в таблице, имеет примерное значение. Более точные расчеты производительности в данной статье не указываются, они могут быть выполнены компаниями – интеграторами.

Сервер Тринити - надежное вложение

Зависимость выбора модели RAID контроллера от количества пользователей серверной системы приведена в таблице ниже (указаны активные пользователи). Цифры носят довольно приблизительный характер, и приведены для того, чтобы понять тенденцию в использовании определенных моделей.

И еще один важный момент. Как настоятельно рекомендуют все учебники, посвященные проектированию сложных систем - проект должен учитывать не только настоящие, но будущие требования к системе.

Существует зависимость и от приложений. Например, SSD кэширование ускоряет работу приложений, ориентированных на чтение. К счастью, это больше 90% Internet приложений. Для операций записи тоже возможно кэширование, но это уже больше как “приятное дополнение” к чтению из-за природы самих приложений.

Рассмотрим теперь модели контроллеров более детально.

6-ая серия RAID контроллеров Adaptec.

Общие характеристики контроллеров 6-ой серии:

Базируются на микросхеме RoC (RAID on Chip) PM8013 8x портов SAS2 (6Гб/сек) PMC-Sierra (дополнительную информацию можно посмотреть на сайте www.pmcs.com;

Модели с максимальным количеством портов – 8 портов SAS 2.0 (6Гб/сек), и слотом 8x PCI-express Gen 2.0;

Кэш память - 512MB DDR2-667 DRAM.

Опционально могут использовать Набор защиты кэша Adaptec Flash Module (AFM-600 Kit) в который входят:

Adaptec RAID 6805 с AFM-600 Flash Module.

Контроллеры 6 серии на уровне стека поддерживают:

Simple Volume, JBOD, RAID 0, 1, 10, 1E, 5, 6, 50, 60 Hybrid RAID 1, 10.

Максимальная производительность ядра контроллера 50 000 IOPS (4 KB blocks, random read).

Производительность для последовательных шаблонов в таблице ниже.

Семейство 6T.

Основная цель появления таких контроллеров семейства 6T - исключить ситуации, когда негибкая часть кабеля (часть, примерно, 2 см длиной после разъема) упирается в крышку или корпус сервера, в радиатор процессора или другие части сервера. Для этого на 6-ой серии контроллеров порты расположены так, чтобы негибкая часть кабеля не выходила за геометрические границы контроллера. Помечено зеленой стрелкой на рисунке. Синий прямоугольник – негибкая часть кабеля.

Adaptec RAID 6805Т с AFM-600 Flash Module.

Семейство 6E

RAID контроллеры для проектов начального класса. Уменьшена оперативная память, по сравнению с обычными контроллерами 6-ой серии, упрощен стек, нет поддержки защиты кэша и экспандеров. Имеют упрощенный стек, поддерживают только Simple Volume, JBOD, RAID 0,1, 10, 1E, т.е., нет поддержки RAID 5,5EE,6, 50, 60, но поддерживают Hybrid RAID 1, 10 (см. раздел «Гибридные Тома» в главе «Основные функции RAID контроллеров» ниже.

Модель 6405E поддерживает максимально 4 диска. Модель 6805E – 8 дисков (поскольку нет поддержки SAS экспандеров). Модель 6405E имеет слот PCI-E 1x, модель 6805E – слот PCI-E 4x ver. 2.

Разъемы портов контроллеров 6-ой серии.

Все семейство RAID контроллеров 6-ой серии поддерживает только порты Mini-SAS.

Для внутренних портов используется разъем – SFF 8087 (internal mini-SAS),

для внешних – SFF-8088 (external mini-SAS).

Сводная таблица для контроллеров 6-ой серии.

7-ая серия RAID контроллеров Adaptec.

Adaptec RAID 71605.

Первый контроллер PCIe 3.0 LP MD2 с 16 портами SAS/SATA 6 Гбит/сек.

Первый контроллер PCIe 3.0 половинной длины с 24 портами.

Первое решение, использующее все преимущества шины PCIe 3.0.

Первое решение, обеспечивающее 450 тысяч IOPS и 6600 МБ/сек.

Первое решение, ориентированное на создание томов на базе SSD.

Впервые в полной мере допускается подключение внешних стоек RBOD, ленточных устройств и автозагрузчиков.

Общие характеристики контроллеров 7-ой серии:

Базируются на микросхеме SRCv RoC (RAID on Chip) PM8015 SRCv 24x порта SAS2 (6Гб/сек) PMC-Sierra (дополнительную информацию можно посмотреть на сайте www.pmcs.com);

Модели с максимальным количеством портов – 24 порта SAS 2.0 (6Гб/сек), и слотом 8x PCI-express Gen 3.0;

Кэш память - 1024 MB DDR3-1333 DRAM.

o Дочерняя плата с flash-памятью;

o Выносной блок суперконденсатора.

Контроллеры 7-ой серии на уровне стека поддерживают: Simple Volume, JBOD, RAID 0, 1, 10, 1E, 5, 6, 50, 60, Hybrid RAID 1, 10 и режим HBA.

Начиная с 7-ой серии RAID контроллеры поддерживают режим HBA, т.е. по сути это не совсем RAID контроллер, это RAID контроллер и HBA на одной плате. См. в описании функций продуктов раздел «Режим HBA».

Прекращена поддержка RAID 5EE (причина в том, что производительность RAID6 из-за усиления архитектуры микросхемы RoC сравнялась с RAID5EE, а по всем остальным параметрам – надежность, легкость в обслуживании и т.д., RAID 6 или аналогичен или лучше RAID5EE, что лишает смысла существование RAID 5EE в стеке современного RAID контроллера).

Максимальная производительность ядра контроллера 600 000 IOPS.

Все семейство RAID контроллеров 7-ой серии поддерживает только порты miniSAS-HD.

Для внутренних портов используется разъем – SFF-8643 (internal mini-SAS HD),

для внешних – SFF-8644 (external mini-SAS HD).

Обратите внимание на сбалансированность диапазонов пропускания со стороны SAS и PCI-E на примере 71605 контроллера – единственное в отрасли решение 16 портов SAS2 в низкопрофильном варианте.

Семейство 7E

RAID контроллеры для проектов начального класса. Уменьшена оперативная память, по сравнению с обычными контроллерами 6-ой серии, упрощен стек, нет поддержки защиты кэша. Имеют упрощенный стек, поддерживают только Simple Volume, JBOD, RAID 0,1, 10, 1E, т.е., нет поддержки RAID 5,5EE,6, 50, 60, но поддерживают Hybrid RAID 1, 10 (см. раздел «Гибридные Тома» в главе «Основные функции RAID контроллеров» ниже).

В отличие от 6E семейство 7E поддерживает экспандеры и имеют такой же разъем 8X PCI-E как и контроллеры без индекса «E».

Семейство 7Q

RAID контроллеры семейства 7Q обладают функцией SSD кэширования. Поддерживается выделение кэша на уровне логического диска. Оставшуюся емкость можно использовать как обычный RAID том. Поддерживается кэш и на чтение, и на запись. Более детальную информацию смотрите в разделе «SSD кэширование» в главе «Основные функции RAID контроллеров» ниже.

Сводная таблица для контроллеров 7-ой серии.

8-ая серия RAID контроллеров Adaptec.

Общие характеристики контроллеров 8-ой серии.

8-ая серия RAID контроллеров является флагманской группой RAID контроллеров на начало 2015 года. И базируется уже на технологии SAS3 (12 Гб/сек). Семейство включает в себя единственный в отрасли 16-портовый RAID-контроллер SAS 12 Гб/с со встроенным флэш-резервированием кэша - всё это в форм-факторе LP/MD2 - ASR-81605ZQ. Максимальные в отрасли для RAID контроллеров 700 000 операций ввода-вывода в секунду (IOPS). Max Cache 3.0 - уникальное для отрасли программное обеспечение уровневого управления и кэширования, обеспечивает хранилищам лучшую экономическую эффективность и производительность.

ASR-8885 имеет 8 внутренних/внешних портов SAS3 12 Гб/сек в низкопрофильном форм-факторе LP/MD2:

Базируются на микросхеме SRCv RoC (RAID on Chip) PMC PM8063 16x портов SAS3 (12 Гб/сек) PMC-Sierra (дополнительную информацию можно посмотреть на сайте www.pmcs.com);

Модели с максимальным количеством портов - 12 портов SAS 3.0 (12 Гб/сек) и слотом 8x PCI-express Gen 3.0;

Кэш память - 1024 MB DDR3-1600 DRAM;

Разъёмы HD miniSAS.

o Опционально могут использовать Набор защиты кэша Adaptec Flash Module (AFM-700), в который входят:

o Дочерняя плата с flash-памятью;

o Выносной блок суперконденсатора.

Модель AFM-700 модуля защиты кэша подходит к 7 и 8 серии контроллеров Adaptec.

Семейство 8Q

RAID контроллеры семейства 8Q поддерживают функцию SSD кэширования. Поддерживается выделение кэша на уровне логического диска. Оставшуюся емкость можно использовать как обычный RAID том. Поддерживается кэш и на чтение, и на запись. Более детальную информацию смотрите в разделе «SSD кэширование» в главе «Основные функции RAID контроллеров» ниже.

Сводная таблица для контроллеров 8-ой серии.

Adaptec RAID 81605ZQ с подключенным блоком суперконденсатора.

6-ая серия HBA Adaptec

Adaptec SAS HBA 6805H.

Общие характеристики HBA 6H серии:

Крайне эффективные, с точки зрения цены, HBA решения, которые предоставляют 4 / 8 внутренних SAS портов (технологии SAS2 6Гб/сек);

Производительность 250000 IOPS с размером блока. 512 Байт и 200000 IOPS с размером блока 4Kбайта;

Все модели имеют низкопрофильный размер LP/MD2 и используют MiniSAS разъемы;

Семейство использует 4x PCI-express Gen 2.0.

Сводная таблица для HBA 6-ой серии.

7-ая серия HBA Adaptec.

Adaptec SAS HBA 71605H.

Общие характеристики HBA 7H серии:

Крайне эффективные, с точки зрения цены, HBA решения, которые предоставляют 16/ 8 внутренних или внешних SAS портов (технологии SAS2 6Гб/сек);

Производительность 1 миллион IOPS с размером блока. 512 Байт и 800000 IOPS с размером блока 4Kбайта;

Поддерживают недисковые устройства;

Все модели имеют низкопрофильный размер LP/MD2 и используют MiniSAS-HD разъемы;

Семейство использует 8x PCI-express Gen 3.0.

Сводная таблица для HBA 7-ой серии.

Общий взгляд на ядро линейки продуктов с точки зрения поддержки функций RAID и HBA.

Информация предоставлена компанией Adaptec by PMC (Россия). Полный текст статьи можно найти

Во время старта сервера, при инициализации RAID-контроллера будет выведено приглашение нажать Ctrl-A для того, чтобы войти в BIOS контроллера. Через некоторое время после нажатия Ctrl-A , Вы попадете в утилиту управления контроллером, где и сможете осуществить все дальнейшие действия по настройке.

В первую очередь, нужно проинициализировать диски (все данные на них будут утеряны!) - в меню A rray Configuration Utility -> Initialize Drives пробелом выбираете все диски и нажимаете Enter.

После этого можно приступать к созданию массивов. Обсуждения выбора уровня RAID, а также размеров логических дисков выходит за рамки данного документа - это должно быть сделано в момент планирования конфигурации.

Для создания RAID-массива следует выбрать пункт меню Array Configuration Utility -> Create Arrays , выбрать (пробелом) диски, которые Вы планируете включить в массив, и нажать Enter. В следующем меню нужно будет выбрать уровень RAID (Array Type); название массива (Array Label); размер массива (Array Size); размер страйпа (Stripe Size) - в данном случае рекомендуется оставить значение, предлагаемое по умолчанию; кэширование при чтении (Read Caching) - рекомендуется Yes; кэширование записи (Write Caching) - рекомендуется Enable when protected by battery; способ создания массива (Create RAID via) - рекомедуется выбрать режим Clear, хотя это потребуется длительного (особенно в случае с SATA дисками большого объема) ожидания создания массива, зато Вы будете избавлены от целого ряда других возможных проблем.

Если был выбран режим создания массива Clear, начнется процедура создания массива. Посмотреть текущий статус можно в меню Manage Arrays и нажав Enter на массиве - необходимо дождаться статуса Optimal (пока не окончился процесс создания массива в строке статуса будет написано Clearing: xx%).

Если Вы создали несколько массивов, то загрузочным будет самый первый из них (в списке Manage Arrays), поэтому, если требуется выбрать другой массив для установки ОС, нужно установить курсор на этом массиве и нажать Ctrl-B, после подтверждения загрузочный массив изменится.

Назначить Hot-Spare диск(и) можно также в меню Manage Arrays , нажав Ctrl-G - будет выведен список свободных дисков, из него пробелом можно назначить Hot-Spare диски (один или несколько). Затем нужно подтвердить сделанный выбор, нажав Enter. Пояснение: Spare диск не входит в состав ни одного RAID-массива, но в случае поломки какого-либо диска в массиве, автоматически займет его место (кроме случая RAID-0).

После этого можно выйти из BIOS контроллера (Esc) и сервер будет автоматически перезагружен.

Теперь можно начинать устанавливать на сервер операционную систему. Для установки Вам скорее всего потребуются драйверы (возможно, их потребуется записать на дискету). Драйверы можно взять с прилагаемого диска, но рекомендуется скачать последнюю версию с сайта Adaptec: http://www.adaptec.com/en-US/support/raid/#sas_raid (выбрав имеющийся контроллер и соответствующую ОС). Дальнейшие инструкции по установке драйвера следует искать в документации на используемую ОС.

После установки ОС настоятельно рекомендуется установить Adaptec Storage Manager (ASM). Это графическое приложение служит для мониторинга и модификации настроек RAID-контроллера и созданных массивов. В случае возникновения каких-либо проблем, Вы будете оповещены (на email или другим способом, который Вы выберете при настройке параметров). Более подробная документация (на английском языке) находится на сайте http://www.adaptec.com

В этом видео рассмотрим процесс создания RAID массива через внешний контроллер Adaptec. Я уже затрагивал тему , а так же . Но, в данной ситуации будем выполнять настройку внешнего контроллера Adaptec ASR-3405, который выглядит следующим образом.

Данный контроллер подключается к материнской плате через слот PCI-Express, а к самому контроллеру подключается корзина с жесткими дисками. И далее, начинается непосредственный процесс настройки.

Включаем сервер и дожидаемся появления сообщения Press Ctrl+A for Adaptec RAID Configuration Utility , т.е. нажмите Ctrl+A для запуска конфигурационной утилиты. Нажимаем, и выполняется запуск утилиты настройки RAID контроллера Adaptec.

После загрузки, запустим утилиту по настройке массива (Array Configuration Utility ). Если RAID массивы уже создавались, то можно зайти в Управление массивами (Manage Arrays ) и увидеть, какие массивы уже были созданы и нормально ли они функционируют. Как вы видите, у меня уже есть зеркальный массив с именем RAID 1_ Mr , по этому, я его удалю, чтобы настроить все с чистого листа. Для этого жмем Enter и выбираем пункт Delete . После чего, появляется сообщение, что ни одного массива не найдено.

Так как вся работа с жесткими дисками будет выполняться через внешний контроллер. Нужно, чтобы этот контроллер видел все диски, с которыми ему предстоит работать. По этому, первым делом нужно выполнить инициализацию жестких дисков, т.е. убедиться, что утилита видит все диски и может с ними работать. Для этого жмем в меню Initialize Drives , и если какой-то из жестких дисков не виден или не получается его выбрать при создании массива. То, из данного списка, выбираем его кнопкой Insert \ Enter , где можно будет выполнить проверку жесткого диска или выполнить низкоуровневое форматирование.

Теперь создадим наш зеркальный массив, для этого выбираем в меню Create Array (Создать массив) \ Кнопкой Insert выделяем нужные нам диски (так как я буду делать зеркальный RAID, то я выбираю жесткие диски одинакового размера) \ Enter \ RAID 1 \ Имя массива: Mirror _2 Tb , все остальное оставляем по умолчанию \ Done . Стоит учесть, что вся информация с жестких дисков, объединяющихся в массив, будет удалена!!!

Если выбрать 3 жестких диска, то станет доступно создание RAID 5, но, мне это не нужно, я хочу создать два зеркальных массива и один обычный том. Поэтому я выделяю два других диска одинакового объема, выбираю так же RAID 1 и задаю имя Mirror_150Gb.

Ну и выбираю последний диск, это у нас будет обычный том, поэтому оставляем по умолчанию значение Volume, ну и имя Volume_300Gb.

Теперь мы видим в управлении массивами, что у нас три массива, два RAID1 и один обычный. Как вы видите, в меню установки операционной системы у нас видны 3 жестких диска, с которыми мы можем работать!!!

Всем привет, сегодня мы с вами будем настраивать контроллер adaptec raid 8885, который попал ко мне на тестирование. У меня в компании мы сейчас выбираем RAID контроллер для серверов с SSD дисками. Ранее я уже оттестировал LSI 9361-8i и предоставил не одну статью, как и с чем пришлось столкнуть при его запуске на сервере HP proliant g7. Пришла очередь adaptec 8885, так же очень свежий контроллер. Думаю статей будет несколько, иначе будет просто длиннющий пост, что не удобно.

Напомню, что HP довольно проприетарный вендор и все в своих серверах производит сам, и не особо дружит, по крайней мере официально с другими вендорами, примером могут служить грабли с установкой в него все того же LSI 9361-8i, я описал метод как их подружить . Когда вы вставите adaptec raid 8885, то в BIOS HP он будет видится как неизвестное устройство, можете смело на это забить, это ни как не повлияет на работу. Единственное, хочу сразу порекомендовать обновить все прошивки на hp сервере , чтобы все было максимально свежее.

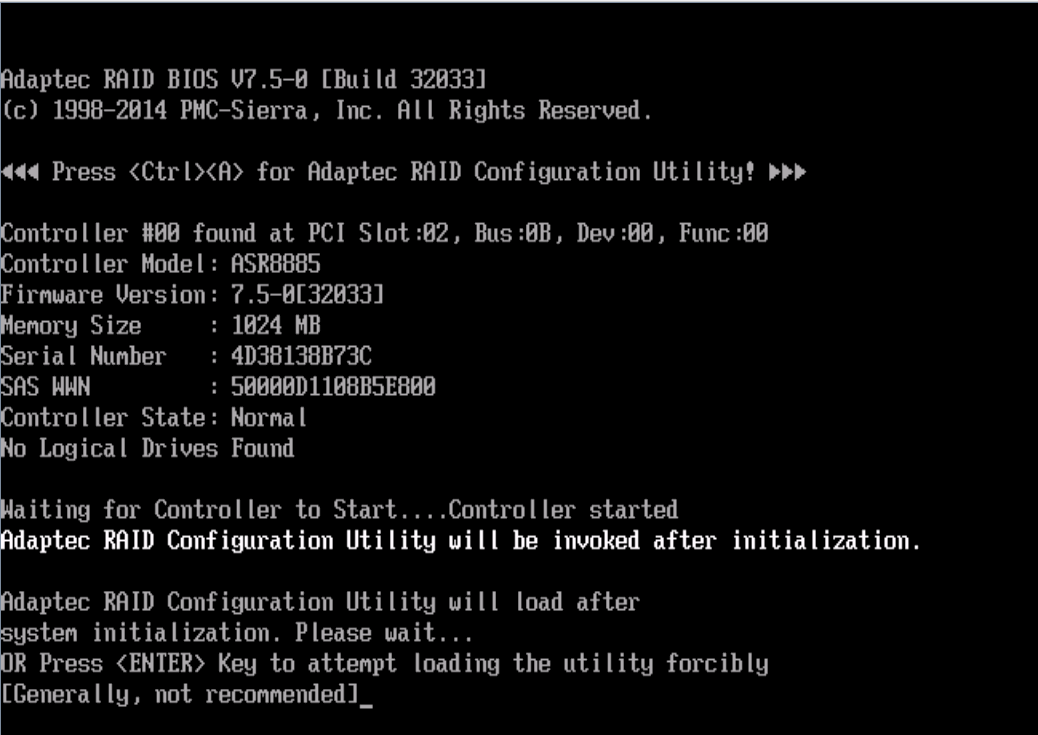

Итак двигаемся дальше и создадим raid массив на нашем adaptec raid контроллере . У меня в арсенале 2 SAS диска под RAID-1 зеркало. для системы и 6 ssd дисков для создания RAID-5 до RAID-10 lun. Для нарезки LUN (Logical Unit Number), логических дисков на raid контроллере, нам поможет встроенная bios подобная утилита Adaptec RAID Configuration Utility (ранее называлась Array Configuration Utility (ACU)). Для попадания в RAID Configuration Utility, далее сокращаем до RCU, нужно перезагрузить сервер и дождаться вот такого окна, в котором просто нужно нажать

возможны другие конфигурации. Еще некоторые сервера, например как мой грузились и не показывали данное окно, для этого приходилось при загрузке нажимать F8 , заходить в меню настройки ILO, сразу от туда выходить и только потом виделся нужный экран. Если у вас UEFI BIOS, то вы можете создавать raid массивы из него, за счет hii (uefi human interface infrastructure), если по русски то утилита для людей:)

В конечно счете мы попадаем в утилиту RCU

Первым делом давайте зайдем в пункт меню Disk Utilities, тут вам покажут все ваши диски, с их моделями и вендорами, а так же тип подключения. У меня 6 ssd Sansung EVO 850 и два HP sas 600 гб.

Выбираем допустим форматирование

Подтверждаем форматирование

Начнется форматирование, по времени занимает по разному все зависит от размера raid диска.

Также можно выбрать Ferify Disk Media, начнется проверка HDD на битые сектора.

Выходим из данного меню и рассмотрим настройки самого контроллера Adaptec.

Заходим в пункт Controller Settings.

Посмотрим основные настройки Controller Configuration. У вас тут будут такие опции:

В Advanced Configuration режиме у adaptec raid controllers можно настроить вот такие значения: